Üdvözlünk az e heti és egyben az első Rackhost Pénteken. Mindenki arról szeretne tudni, hogy hogyan lehet fentebb jutni a Google keresési listáján. Azonban azt sem árt tudatosítani, hogy mit ne csináljunk.

heti és egyben az első Rackhost Pénteken. Mindenki arról szeretne tudni, hogy hogyan lehet fentebb jutni a Google keresési listáján. Azonban azt sem árt tudatosítani, hogy mit ne csináljunk.

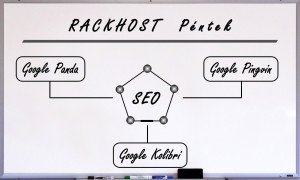

Először ejtsünk pár szót magáról az algoritmusról. Majd pedig bemutatnánk pár algoritmust amit valószínűleg a többség már ismer.

Google algoritmusok

A Google keresési találatokat sorba rendező algoritmusán az elmúlt években rengeteg változást hajtottak végre. Általában minden évben egy-egy nagyobb csomagba gyűjtik a változtatásokat, amik alapjaiban szokták megváltoztatni a honlapszerkesztési technikákat, illetve a keresőoptimalizálást. 2011-ben a Panda, 2012-ben a Penguin, 2013-ban pedig a Hummingbird frissítés hozta el a nagy változásokat

Google Panda

A Google Panda 2011 februárjában került bevezetésre. A változtatás fő célja az volt, hogy a keresési találatok között hátra sorolják az alacsony minőségű, kevés érdemi tartalommal bíró honlapokat, és a minőségi információt nyújtó oldalak kerüljenek a találatok elejére. Általánosságban a változtatással a hírportálok és a közösségi oldalak kerültek előnybe, és a nagy mennyiségű reklámot tartalmazó oldalak lejjebb csúsztak. Az algoritmus változtatásainak alapját egy kutatás adta, amelyben a Google tesztelői több ezer weboldalat pontoztak a minőség, a dizájn, a megbízhatóság, a sebesség, illetve a visszalátogatások tekintetében. Ezután a Panda algoritmus a hasonlóságokat keresett a magas illetve az alacsony minőségű honlapok között azért, hogy ezek a hasonlóságok alapjául szolgálhassanak a rangsorolásnak. A legnagyobb újítása a Pandának az volt, hogy a honlap különböző aloldalai helyett, az egész honlapot értékeli.

Google Penguin

A Google Penguin 2012 áprilisában került be a keresési algoritmusok közé. A frissítés fő célja az volt, hogy azokat az oldalakat, amelyek a Google Webmester útmutatójában foglaltakkal szemben álló keresőoptimalizálási technikákat alkalmaznak, hátrébb kerüljenek a keresési találatok között. Ezek a technikák leginkább olyan tevékenységek, amelyek spamre építenek. A Penguin frissítés is követi a Google egyik legfőbb célkitűzését, mégpedig a minőségi internetes tartalmak térnyerését. Általánosságban azok a honlapok kerültek a leginkább hátrébb, amelyek indokolatlanul sok linket helyeztek el különböző internetes felületeken, amelyeknek a legtöbbször nem volt releváns kapcsolata a honlappal.

Google Hummingbird

A Google Hummingbird algoritmusa 2013 szeptembere óta aktív. A Google a 15. születésnapjára egyféle ajándéknak szánta a Google-t használók számára, amelynek a legfontosabb feladata a kereső és a felhasználók közötti kapcsolat még emberibbé tétele, illetve a feltett kérdésekre adandó minél pontosabb válasz lenne. Az elmúlt év frissítései közül a Hummingbird vagyis a Kolibri a legnagyobb horderejű, a Google szerint 2001 óta nem volt ekkora változás a keresőmotor működésében. A legfontosabb újítás az, hogy a kereső már nem beírt kulcsszavakat elemez, hanem megpróbálja értelmezni a beírt kérdést. A tapasztalatok szerint nagyjából a keresések 90%-át érintette a frissítés, legnagyobb hatással pedig értelemszerűen a hosszú, összetett kérdésekre volt, hiszen ezekre lehet pontosabb választ adni. Összességében a Kolibri frissítés után továbbra is a minőségi tartalomra kell koncentrálni, a honlapokat, illetve a tartalmakat pedig úgy kell szerkeszteni, mintha kérdésekre akarnánk választ adni, hiszen a Google is ebbe az irányba fog elmozdulni.

Mi az, amit kerüljünk el:

I. Duplikált tartalom

Amikor behatóbban kezdünk el foglalkozni a SEO-val, akkor előbb, vagy utóbb szembe kerülünk a duplikált tartalom problémájával. Ez a probléma korántsem új keletű, már elég rég óta jelen van, amiből az következik, hogy számos módszert ismerünk a duplikálás megoldására. Az alábbiakban ezek közül ismertetünk párat.

1. Blokkolás a Robots.txt használatával

Ez a legrégebbi, és a legszélesebb körben alkalmazott módszer. A lényege az, hogy a robot.txt blokkolja az adott domaint, vagy oldalt, ezért a Google keresőrobotja nem lesz képes azt felkeresni és indexelni. Ennek a megoldásnak az a hátránya, hogy ha valaki hivatkozik az oldalunkra, akkor a Google azt sem fogja tudni követni, így optimalizálás szempontjából nem ez az ideális módszer, viszont bátran használhatjuk, ha egyszerűen csak blokkolni szeretnénk az adott tartalmat, attól függetlenül, hogy az duplikált-e, vagy sem.

2. Meta Robots Noindex/Follow tag

<meta name=”robots” content=”noindex,follow” />

Ezzel a taggel (noindex) el tudjuk érni, hogy a keresőmotor nem indexelje az oldalt, ami pedig lehetővé teszi a duplikálás elkerülését. A follow érték viszont azt közli a keresőmotorral, hogy kövesse az oldalon elhelyezett linkeket. Ez a megoldás a blogok esetében alkalmazható a leghatékonyabban, mivel itt az elsődleges tartalom, amit indexelni kell, az maga a blog, a másodpéldány pedig az archivált tartalom, ami ugyan régebbi tartalom, viszont hasznos lehet, ha meg tud jelenni a keresőkben.

3. Redirect 301

A legtöbb esetben az lehet az optimális megoldás a duplikált tartalom ellen, ha a Redirect 301 segítségével átirányítjuk a keresőt a duplikált oldalról az eredeti oldalra. Amikor egyetlen oldalba olvasztjuk azokat az oldalakat, amik potenciálisan jó page rankkel rendelkeznek, akkor ezek nem fognak többé egymással versenyezni, hanem megnövelik a relevanciát, ezt pedig pozitív hatással lesz a SEO-ra. A Redirect 301-et olyan esetekben érdemes alkalmazni, amikor az átirányítás nem befolyásolja negatívan a felhasználói élményt. Ilyen esetek például az IP cím, az index fájl, www, vagy www nélküli tartalom átirányítása.

4. Canonical tag

Egy másik módszer a duplikált tartalom kezelésére a rel=canonical tag használata. A rel=canonical taggel ugyanakkora page rankre tehetünk szert, mint a Redirect 301-el, viszont ezt egyszerűbb alkalmazni.

A tag a honlap HTML fejlécének a részét képezi, és így nézhet ki:

<link href=”http://www.pelda.hu/aloldal/” rel=”canonical” />

Ez a tag közli a keresőmotorokkal, hogy az adott oldalt úgy kezeljék, mintha a www.pelda.hu/aloldal URL másolata lenne és minden link és tartalom, ami a másolaton található valójában az eredeti oldalhoz tartozik. Olyan honlapok esetében lehet hasznos, amelyek több kategóriát és alkategóriát különböztetnek meg, és eltér a kategóriák elérési útja, de a tartalom azonos.

5. Alterna link tag

Ez a megoldás sok ponton hasonlít a Canonical tag-re, viszont ennek az alkalmazása a nemzetközi, vagy többnyelvű SEO-ban jellemző.

<link rel=”alternate” hreflang=”en” href=”http://www.pelda.com/valami” />

<link rel=”alternate” hreflang=”en” href=”http://www.pelda.co.uk/valami” />

<link rel=”alternate” hreflang=”en” href=”http://www.pelda.de/valami” />

Az alterna tag segít a Google-nek, hogy minél könnyebben be tudja azonosítani az adott országnak megfelelő tartalmat. Ennek a tag-nek az a hátránya, hogy előfordulhat, hogy a Google duplikált tartalomként fogja kezelni néhány oldalunkat. Olyan oldalak esetén vehető igénybe, amelyeknek egynél több ország a célcsoportja.

6. Google Webmestereszközök

A Google Webmestereszközök lehetővé teszik, hogy beállítsuk a honlapunk által preferált domaint, és azt is, hogy differenciáltan tudjuk kezelni a különböző URL paramétereket. Ennek a módszernek az a legnagyobb hátránya, hogy ez a módszer kizárólag a Google keresőmotorja estében működik. A Bingre, vagy más keresőmotorokra semmilyen hatást nem fognak gyakorolni az itt végrehajtott beállítások.

Fontos megjegyezni, hogy a fentiekben ismertetett megoldásokat nem csak duplikált tartalom esetén lehet alkalmazni, hanem általánosságban is. Amennyiben van olyan aloldala a honlapunknak, amit nem szeretnénk, ha indexelnének a keresőmotorok, akkor érdemes megtenni a megfelelő lépéseket, különben előfordulhat, hogy a kereső 404-es hibaként kezeli az adott oldalt.

II. Linképítés gyenge tartalommal

A google nem preferálja a vendégbloggolást mint linképítési technikát. Több ilyen vendégblog-hálózatot le is büntetett. Most azonban még ezen is változtattak. Tehát frissültek a Google Webmester Irányelvei és ez azt jelenti, hogy mostantól a gyenge vendégbejegyzéseket mint tartalmi tényezőket is spam-k minősítette a Google. Következésképpen óvakodjunk ettől a technikától ugyanis már a gyenge tartalomból kifolyólag is spam-t kaphatunk függetlenül attól, hogy bejegyzésünk tartalmaz-e linket vagy sem.

III. Ne használjunk „Keywords Meta Tag”-t, fölösleges

Ne adjunk hozzá keywords meta tag-t sok kulcsszóval, hogy színesebbé tegyünk a palettánkat reménykedve, hogy ezzel majd fentebb jutunk a keresési listán, mert NEM! A Google nem használja.

Jövő Pénteken várunk újabb érdekességekkel és hasznos tudnivalókkal.